Jak sztuczna inteligencja odbiera pracę i co z tym począć

Kategoria: Innowacje w biznesie

Dr filozofii, wykładowca w Katedrze Filozofii na UE w Krakowie

więcej publikacji autora Tomasz Kwarciński

Wystarczy obejrzeć w sieci coraz popularniejszy film, by zaczęły się pojawiać wątpliwości. Na nagraniu widać jak autopilot w samochodzie Tesla przewiduje możliwość kolizji dwóch jadących przed nim pojazdów – w reakcji rozpoczyna automatyczne hamowanie, co pozwala uniknąć zderzenia. Co jednak się stanie, gdy pojazd autonomiczny zdoła przewidzieć kolizję, ale nie będzie w stanie jej uniknąć? Czyje życie i zdrowie powinno być w wówczas chronione: pasażerów czy przechodniów? Nawet jeśli zgodzimy się, że pasażerowie mają pierwszeństwo, czy nadal będziemy tak myśleć, jeśli alternatywą będzie wjechanie w grupę ludzi? A co jeśli samochodem autonomicznym podróżuje młody mężczyzna, a na jezdni znajduje się staruszka, kobieta w ciąży, dziecko, pies?

Stawianie tego typu pytań wydaje się niedorzeczne, ma ono jednak głęboki sens. Jak zauważają autorzy projektu “Moral Machine”, po raz pierwszy w historii stajemy przed koniecznością oddania decyzji moralnych w gestię maszyn sterowanych sztuczną inteligencją. Co więcej, wydarzy się to nie gdzieś daleko na jakiejś nieznanej wojnie, lecz tuż za rogiem, na ulicy, przy której bawią się nasze dzieci. Czy wiemy, w jaki sposób zaprogramować pojazdy autonomiczne? Kto powinien o tym decydować? Samochody autonomiczne programowane będą przez konkretnych ludzi, przedstawicieli określonych kręgów kulturowych, którzy mają specyficzne intuicje moralne, nie zawsze uniwersalnie podzielane.

Poszukując odpowiedzi na te pytania naukowcy z Massachusetts Institute of Technology zbudowali stronę internetową “Moral Machine”, na której każdy internauta mógł podjąć własne decyzje, kto powinien przeżyć, a kto zginąć w kolizji pojazdu autonomicznego. Projekt zyskał ogromną popularność, na platformie zgromadzono 40 milionów decyzji, podjętych w 10 językach, od ludzi mieszkających w ponad 200 krajach. Konkluzje tego eksperymentu zostały ostatnio opublikowane w czasopiśmie Nature. Okazało się, że wśród uczestników można wskazać pewne dominujące poglądy. Większość badanych przedkłada:

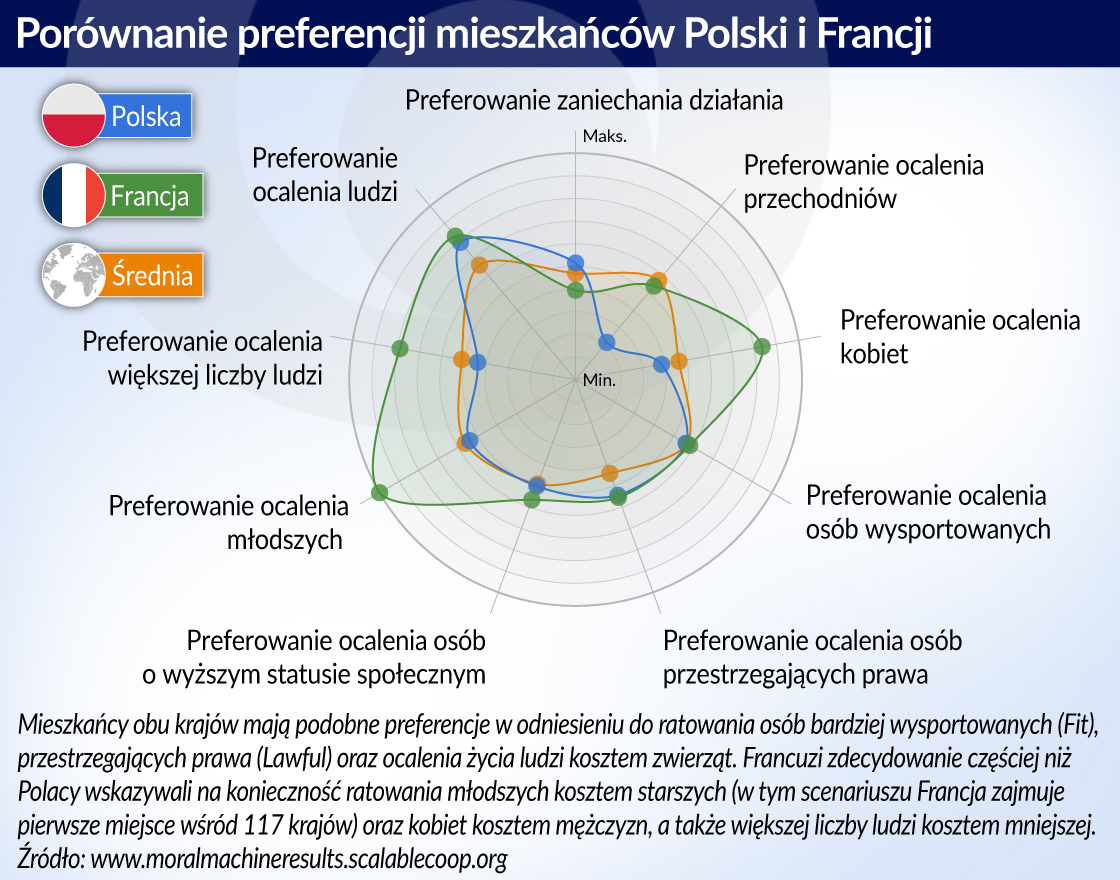

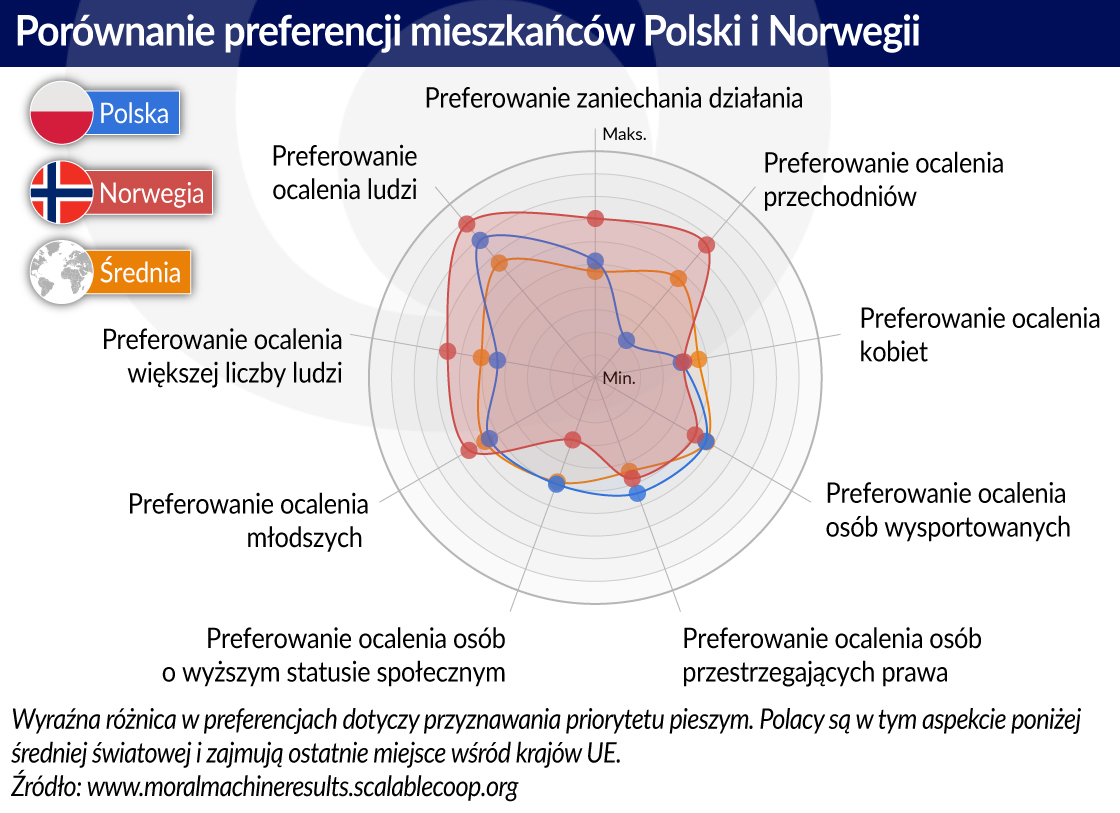

Niemniej jednak zaznaczyły się również istotne różnice w poglądach w zależności od tego, do jakiej kultury należeli badani. Autorzy artykułu wyróżnili trzy zbiory: (1) kraje szeroko rozumianego Zachodu, do których należą Ameryka Północna i wiele państw europejskich, w których dominuje kultura chrześcijańska, protestancka lub prawosławna, (2) kraje Wschodu, do których zaliczono wiele państw Dalekiego Wschodu, takich jak Japonia czy Tajwan z ich kulturą konfucjańską, a także kraje islamskie, jak Indonezja czy Arabia Saudyjska, wreszcie (3) szeroko rozumiane kraje Południa, czyli kraje Ameryki Łacińskiej, Ameryki Centralnej oraz Południowej, a także kraje, w których silne są wpływy francuskie. W tym badaniu Polska znalazła się wśród krajów Zachodu, ale już Czechy, Węgry i Słowacja zostały zaliczone do krajów Południa.

Okazuje się, że preferencja, zgodnie z którą w kolizji należy dawać pierwszeństwo młodszym uczestnikom ruchu drogowego, była rzadziej wyrażania w krajach Wschodu, zaś zdecydowanie częściej w krajach Południa. Z drugiej strony, mieszkańcy krajów Południa wyrażali słabsze preferencje dla stawiana życia ludzi ponad życiem zwierząt w porównaniu z mieszkańcami dwóch pozostałych grup krajów. Co ciekawe, różnice w poglądach dają się przyporządkować do charakteru kultury, do której należą respondenci. Na przykład, mieszkańcy krajów Wschodu o bardziej kolektywistycznej kulturze, częściej preferowali ratowanie życia starszych osób ponad młodszych, podczas gdy w krajach Zachodu preferencja była odwrotna.

Wyniki tych badań mają istne znaczenie praktyczne. Z jednej strony decydenci polityczni będą musieli wprowadzić do porządku prawnego przepisy regulujące kwestie decyzji moralnych podejmowanych przez sztuczną inteligencję (dotychczas jedynym krajem, który takie regulacje wprowadził, są Niemcy). Z drugiej strony korporacje motoryzacyjne, dostarczające swoje produkty na różne rynki (zarówno te o kulturze bardziej liberalnej, jak i bardziej kolektywistycznej) będą musiały wziąć pod uwagę odmienne preferencje mieszkańców (i kryjące się za nimi intuicje moralne). Niewykluczone również, że zaprogramowane przez zachodnich producentów pojazdy w długim okresie przyczynią się do zmiany pewnych głęboko zakorzenionych intuicji i przeobrażą nie tylko dotychczasowy sposób organizacji ruchu ulicznego, lecz także nasze myślenie na temat dobra i zła.

Analiza opinii ludzi na temat tego, jaką decyzję powinna podjąć sztuczna inteligencja, która kieruje samochodem autonomicznym, są ważne z jeszcze jednego powodu. Pokazują, że dociekania filozofów moralności mają bardzo duże znaczenie praktyczne. Scenariusze, które zostały umieszczone na stronie “Moral Machine” opierały się na tzw. dylemacie wagonika (trolley problem), eksperymencie myślowym sformułowanym już w końcu lat sześćdziesiątych ubiegłego wieku przez brytyjską panią filozof Philippę Foot w kontekście sporów o tzw. aborcję.

Dylemat ten polega na wyobrażeniu sobie, że po torze, na którym znajduje się grupa pięciu osób, jedzie wagonik, którego nie sposób zatrzymać. Jeśli wagonik uderzy w ludzi, z pewnością wszyscy zginą. Przechodząc tamtędy dostrzegasz jednak, że mógłbyś skierować wagonik na boczny tor, na którym znajduje się tylko jedna osoba. Czy powinieneś przesunąć przekładnie i zmienić tor, po którym porusza się wagonik? Większość studentów różnych kierunków ekonomicznych, z którymi rozmawiałem na ten temat, odpowiadała, że tak właśnie należy zrobić. W odpowiedzi na prośbę o uzasadnienie swojej decyzji wskazywali konieczność minimalizacji zła lub fakt, że zmiana toru przyniesie bardziej korzystne skutki. Zdarzały się, choć dużo rzadziej, odpowiedzi przeciwne, że nie mamy prawa “bawić się w Boga” decydując, kto ma żyć, a kto nie, bądź arbitralnie pozbawiać kogoś prawa do życia. Podobnie jak w badaniu naukowców z MIT okazało się, że studenci mają zarówno utylitarystyczne (maksymalizacja korzystnych skutków), jak i deontologiczne (poszanowanie praw jednostki) intuicje moralne. Dużym zaskoczeniem jest zwykle fakt, że nie ma jednej najlepszej odpowiedzi na pytanie, czy powinienem przesunąć dźwignię zmieniającą tor jazdy wagonika.

Ludzie mają odmienne intuicje moralne, a etycy formułują przekonujące argumenty na poparcie różnych możliwych wariantów decyzji. Opublikowane w czasopiśmie Nature wyniki badań świadczą o tym, że żywione przez ludzi opinie moralne są zróżnicowane kulturowo. Która z nich powinna zatem zostać zaimplementowana w oprogramowaniu samochodów autonomicznych? Opinia najpopularniejsza czy najlepiej uzasadniona? Trzeba zdawać sobie sprawę z tego, że standardy etyczne wprowadzane w samochodach autonomicznych w postaci algorytmów będą wpływać na intuicje moralne ludzi. W algorytmach „zaszyte” są bowiem opinie samych programistów. Analiza etyczna sztucznej inteligencji staje się więc nieodzowna.

Tomasz Kwarciński jest analitykiem w Polskim Instytucie Ekonomicznym i wykładowcą na Uniwersytecie Ekonomicznym w Krakowie.